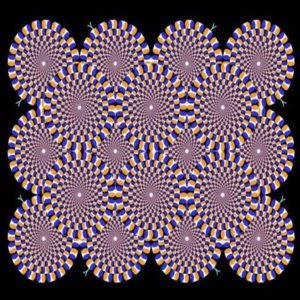

Ilusões de óptica sempre fizeram sucesso na internet – quem não sente o cérebro dar aquela cambalhota quando vê a bailarina girar?

Para entender por que nosso cérebro é enganado, cientistas do Adaptive Brain Lab da Cambridge University modelaram uma rede neural para fazer com que ela enxergasse e tivesse a mesma percepção visual de movimento de um ser humano.

Para montar a chamada MotionNet, a equipe de pesquisadores, liderados pelo neurocientista Reuben Rideaux, usou dados coletados desde a década de 1950 em estudos de percepção de movimento humano. O passo seguinte foi treinar a rede neural para estimar a velocidade e a direção das sequências de imagens captadas (como nossos olhos fazem).

Fora do cérebro

“É muito difícil medir diretamente o que está acontecendo dentro do nosso cérebro quando percebemos o movimento – mesmo nossa melhor tecnologia médica não pode nos mostrar todo o sistema em funcionamento. Com o MotionNet, podemos explorar características do processamento visual humano que não podem ser medidas diretamente no cérebro”, disse Rideaux, principal autor do estudo, em um comunicado.

Treinada sobre os processos mentais humanos ao olhar uma imagem (principalmente aquelas que enganam nossa percepção), a inteligência artificial descreve como as informações de espaço e tempo são combinadas em nosso cérebro, resultando naquilo que vemos ou pensamos ver quando acompanhamos imagens em movimento.

Phi reverso

O experimento envolveu o fenômeno chamado de phi, que é o movimento aparente criado quando dois estímulos ópticos próximos são apresentados em alternância, em uma frequência relativamente alta.

“Por exemplo, se houver um ponto preto à esquerda de uma tela, que desaparece enquanto outro ponto preto aparece à direita, vamos ‘ver’ o ponto se movendo da esquerda para a direita – isso é chamado de movimento phi. Mas se o ponto que aparece à direita é branco em um fundo escuro, ‘vemos’ o ponto se movendo da direita para a esquerda, no que é conhecido como movimento phi reverso”, diz o comunicado.

Essa dinâmica foi apresentada à MotionNet. Por ter sido treinada para ver da mesma maneira que o cérebro de um ser humano, foi isso o que a IA enxergou e interpretou: pontos “andando” quando, na verdade, nada se movia, em um clássico erro de percepção.

A diferença é que, com a MotionNet, os pesquisadores puderam acompanhar o processo mental seguido pela rede neural para compreender (erradamente) o que estava vendo. Segundo Rideaux, o phi reverso ativou neurônios sintonizados na direção oposta ao movimento real.

Mais perto, mais rápido

Os pesquisadores também descobriram que a velocidade do movimento phi reverso é afetada pela distância dos pontos, ao contrário do que eles previram: se os objetos eles estão mais longe, parecem se mover mais lentamente do que quando estão próximos – quantos mais perto, mais rapidamente eles parecem se mover.

“Já sabemos sobre o movimento phi reverso há muito tempo, mas o novo modelo gerou uma previsão completamente nova sobre como o experimentamos, e de uma maneira que ninguém jamais testou antes”, disse Rideaux.

A percepção visual de movimento é adquirida pelo cérebro enquanto crescemos, seja calculando se teremos uma folga para atravessar a rua sem perigo de sermos atropelados ou agarrando uma bola em movimento. Quando adultos, fazemos isso automaticamente: o cérebro, em uma fração de tempo, processa padrões como os de mudança de luz, mas isso nem sempre dá certo.

As descobertas desse estudo, publicado agora no Journal of Vision, deverão ser ainda validadas em pesquisas com seres humanos mas, segundo o coautor do estudo, o neurocientista Andrew Welchman, “esperamos preencher muitas lacunas no entendimento atual de como essa parte do nosso cérebro funciona, e saber em qual parte do cérebro se concentrar vai economizar tempo”.

Fonte: Tecmundo.

Obs: As informações acima são de total responsabilidade da Fonte declarada. Não foram produzidas pelo Instituto Pinheiro, e estão publicadas apenas para o conhecimento do público. Não nos responsabilizamos pelo mau uso das informações aqui contidas.